北大楊仝團隊發布FairyR1模型:5%參數量數學和代碼能力超越滿血DeepSeek

北京大學楊仝教授團隊近期發布了其在高效大型語言模型研究方向的一項新成果——FairyR1-32B模型。該模型基于DeepSeek-R1-Distill-Qwen-32B基座,通過結合微調與模型合并技術構建。研究探索了在參數量大幅減少的情況下,模型在特定任務上實現與更大模型相當甚至更優性能的可能性。該研究得到了國家自然科學基金委項目(624B2005, 62372009)的資助。FairyR1-32B模型已在huggingface開源:https://huggingface.co/PKU-DS-LAB/FairyR1-32B。

FairyR1-32B模型是在團隊前期TinyR1工作基礎上進行的進一步探索,沿用了“分合蒸餾”的研究思路,提出了多種改進方法,包括自我合并、多教師交叉蒸餾、輕蒸餾等方法,并在數據處理進行了優化,模型精度有了顯著提升。

本次工作重點改進了蒸餾數據的構建流程,對來源于AI-MO/NuminaMath-1.5(數學)和open-thoughts/OpenThoughts-114k(代碼)等數據集的原始數據,通過多個“教師模型”生成答案,隨后對問答數據進行精心篩選、結構調整與思維鏈優化,并進行多階段篩選。篩選過程包括基于答案的正確性驗證(針對數學數據),以及基于長度的篩選(數學數據保留2k-8k tokens范圍,代碼數據保留4k-8k tokens范圍),最終構建了更具針對性的約6.6k條數學數據和約3.8k條代碼數據用于訓練。

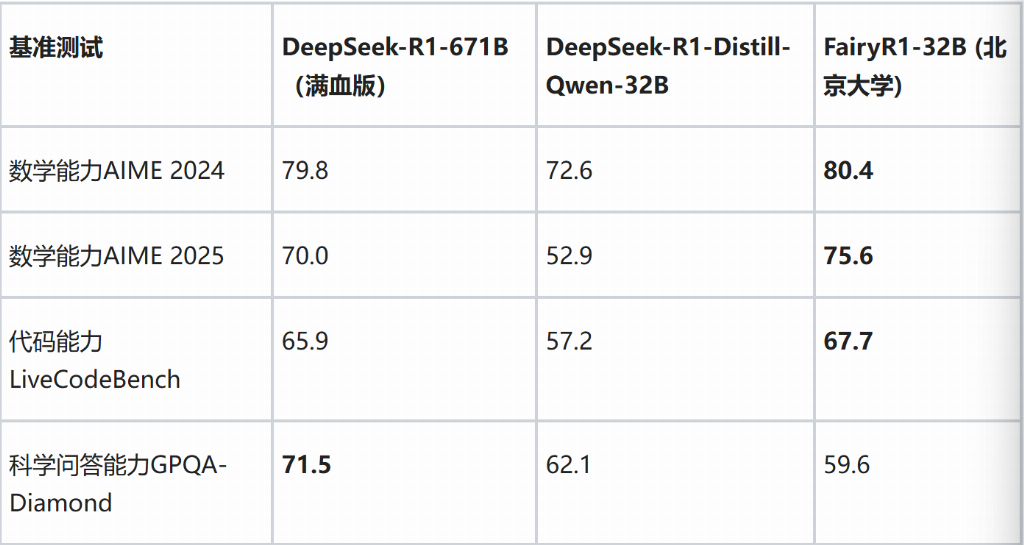

在模型結構方面,研究團隊嘗試訓練兩個領域(數學和代碼)的專業模型進行合并,旨在進一步優化流程和資源消耗。這兩個專業模型在一致的訓練參數下(例如相同的學習率和批次大小)獨立訓練約5個周期后,利用AcreeFusion工具進行了合并。在多個公開基準測試中,FairyR1展現出了在低參數量下的競爭力表現。以下為FairyR1與DeepSeek-R1-671B及DeepSeek-R1-Distill-Qwen-32B在部分基準上的得分對比:

從測試結果可以看出,FairyR1-32B在AIME 2025和LiveCodeBench基準上得分略高于DeepSeek-R1-671B,在AIME 2024上表現接近。在GPQA-Diamond科學基準上,FairyR1的得分低于DeepSeek-R1-671B。這些結果表明,FairyR1在采用DeepSeek-R1-Distill-Qwen-32B基座并經過特定技術處理后,能夠在約5%參數量的情況下,在數理和編程等領域實現與大型模型相當或略優的性能水平,但在科學等其他領域可能存在差距。這項工作探索了通過優化的數據處理和模型融合技術,在保證特定任務性能的前提下,大幅降低模型規模和潛在推理成本的可能性。

北京大學楊仝教授團隊表示:“FairyR1-32B模型是我們探索高效大型語言模型技術路線的階段性成果。通過對蒸餾和合并方法的改進,我們初步驗證了在有限資源下實現高性能模型的可行性。”

團隊成員:李旺、周俊廷、劉文睿、姚一倫、王融樂、楊仝

消費界所刊載信息,來源于網絡,傳播內容僅以學習參考使用,并不代表本站觀點。本文所涉及的信息、數據和分析均來自公開渠道,如有任何不實之處、涉及版權問題,我們會及時處理,舉報投訴郵箱:Jubao_404@163.com,

未經書面授權不得復制或建立鏡像,違者必究。

Copyright © 2012 -2023 CONSUMER TIMES. All Rights Reserved.

深圳市贏銷網絡科技有限公司版權所有

粵ICP備14076428號

粵公網安備 44030702005336號

粵公網安備 44030702005336號